AI小圆桌第一期 | IJCAI2021 浙大分享会

6月23日晚,我们在线上举办了协会第一期“AI小圆桌”活动,该系列活动主要主题是邀请在世界顶级会议上发表论文的老师和同学,来与大家分享论文的细节,提供一个交流的机会,启发大家创新的思维。本次活动借刚发布结果的IJCAI2021会议,邀请了三位浙大的老师和同学,与大家进行分享。

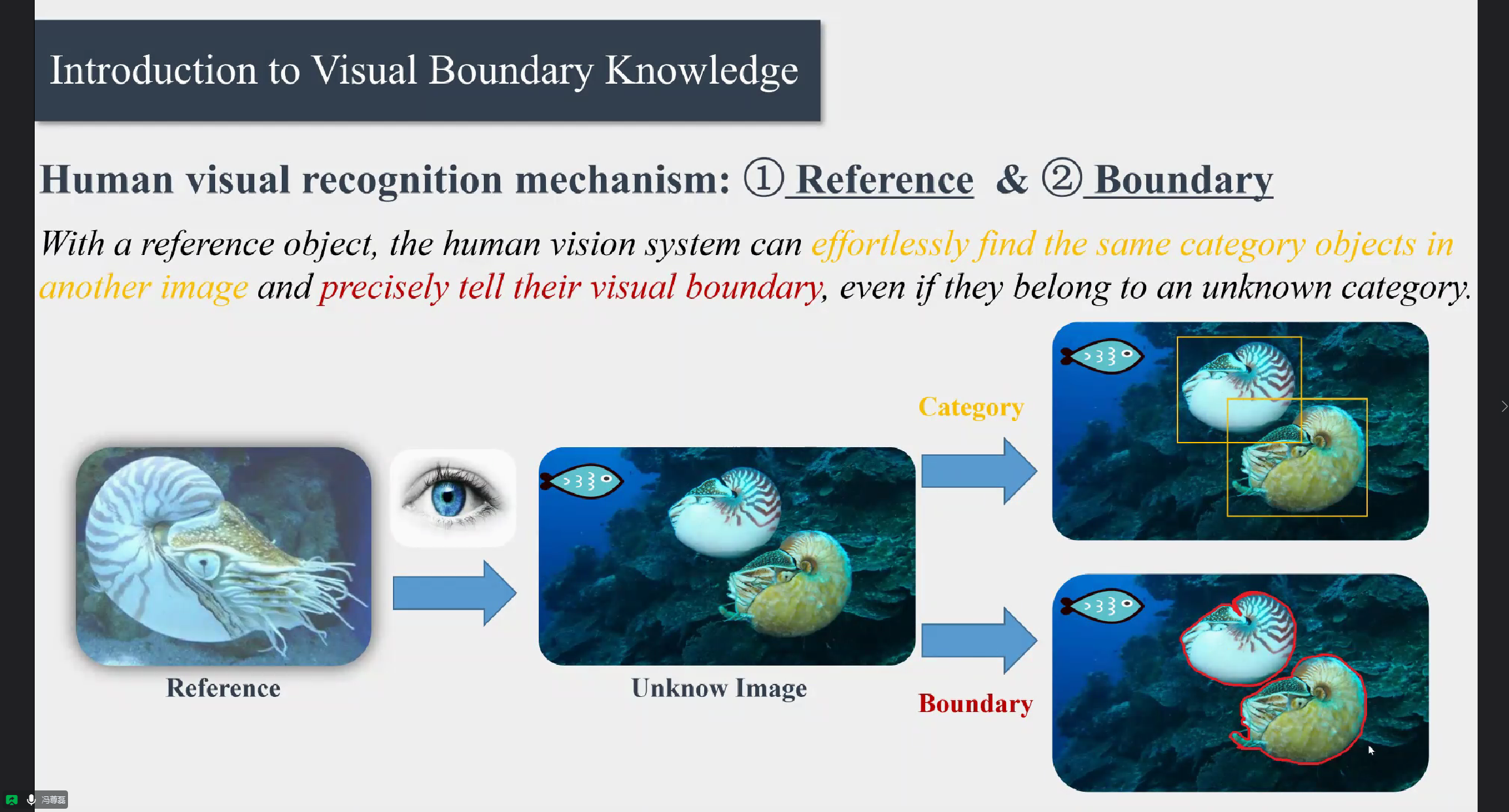

第一位分享嘉宾是浙江大学软件学院教师冯尊磊,论文题目为《Boundary Knowledge Translation based Reference Semantic Segmentation》。论文主要着眼于边缘的分割。冯老师发现,对于未知类别物体的一张图片,人眼视觉可以毫不费力地识别物体的边缘。然而,现有深度网络的训练需要依赖大量类别相关的标注数据,这似乎与人眼不需要类别知识也能准确识别边界有些冲突。受此启发,本文提出了一种基于参考图片的知识转移分割网络,该网络可以将不相关类别的分割边界知识转移到新类别图像的分割网络中。仅需几张目标类别标注数据,所提出的方法可以取得接近全监督的分割效果。

浙江大学计算机学院在读博士谭泽琦随后为我们带来论文《A Sequence-to-Set Network for Nested Named Entity Recognition》的分享。他关注与一个命名实体识别(NER)的问题,是自然语言处理中一个被广泛研究的任务。最近,越来越多的研究集中在嵌套NER。现有的基于跨度的方法存在着搜索空间巨大和实体之间缺乏交互的问题。我们设计了一个序列到集合的模型来解决这些问题。实验表明我们的模型在三个广泛应用的数据集上取得了当前最好的性能。

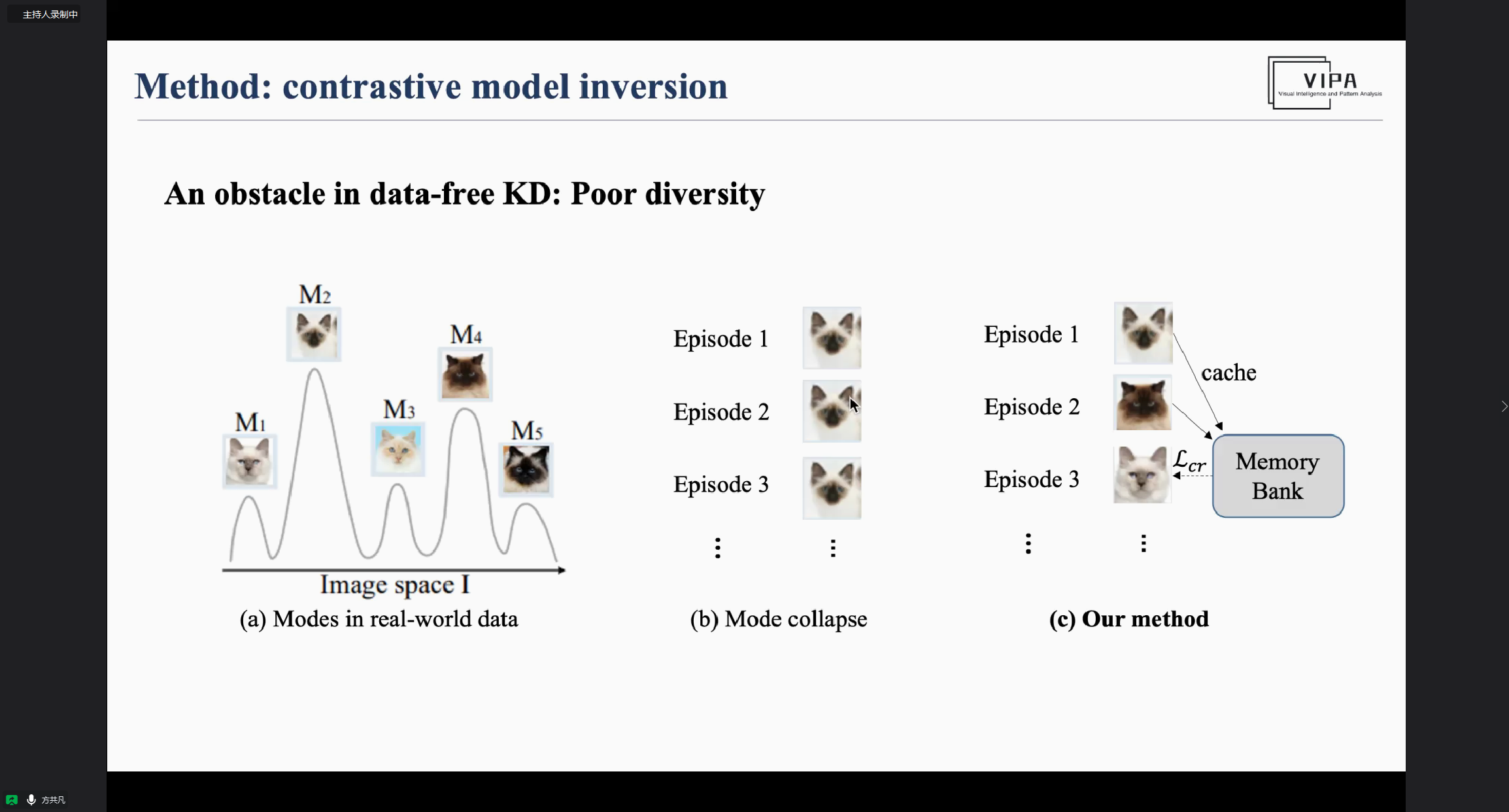

最后,浙江大学计算机学院在读研究生方共凡,为我们带来论文《Contrastive Model Inversion for Data-free Knowledge Distillation》的解读。无数据知识蒸馏 (Data-free Knowledge Distillation) 是一种基于合成数据的模型压缩技术。该技术通过“逆向”模型参数来合成训练所需要的样本,能够在保护原始数据隐私的前提下,有效地缩小模型的规模。然而,无数据知识蒸馏通常面临着严重的模式塌缩的问题,即样本多样性不足,无法完整地迁移原始模型的知识。为了解决这一问题,本文提出了一种基于对比学习思想的无数据蒸馏方法,将多样性建模为一个实例判别(Instance Discrimination)问题,并且引入历史合成样本作为参考,提高新样本的可区分度。实验表明,本方法能够更完整地“逆向”模型所学习到参数,从而提升知识蒸馏的效果。

会议过程中节选的一些图片展示如下: